著者:GOZEN AI Lab管理人

生成AIエンジニア(オープンバッジ取得)生活や業務に潜む「面倒くさい」を手放すため、生成AIを活用した業務効率化施策、自動化ワークフローの構築・運用などを手がけ、実践と継続的な改善を通じて仕組みづくりを推進している。

結論:AIは“文字”じゃなく“カケラ”で理解している。

「トークン」という言葉を聞くけれど、具体的にそれが何を指し、どう私たちのAI利用に関わってくるのか、よく分からない…と感じている方も多いのではないでしょうか。

この記事では、そんなAIの「トークン」について、専門知識がない方でもスッキリ理解できるように、仕組みから料金、実際の活用法までを分かりやすく解説します。この記事を読めば、AIとのコミュニケーションがもっとスムーズになり、賢くAIを使いこなせるようになるはずです。

AIトークンとは何か?AIが言葉を理解する仕組みの基本

簡単に言うと、AIにおける「トークン」とは、AIが人間の言葉や文章を理解し、処理するために使われる最小の単位のことです。

私たちは普段、言葉を「単語」や「文」として認識していますよね。例えば、「こんにちは」という言葉は一つの単語です。しかし、AIはそのままでは言葉を理解できません。コンピューターは数字や記号の集まりとして情報を処理するため、人間の言葉をAIが理解できる形に分解・変換する必要があります。

この「分解された言葉の最小単位」がトークンです。AIは、文章をトークンの並びとして捉え、それぞれのトークンが持つ意味や、トークン同士の関係性を学習しています。

例えるなら、私たちが文章を理解する際に「単語」を単位とするように、AIは「トークン」を単位として言葉を扱っている、と考えてみてください。

なぜAIに「トークン」が必要なのか?

AI、特にChatGPTやGeminiのような大規模言語モデル(LLM)は、膨大なテキストデータを使って学習しています。この学習や、私たちが入力した文章(プロンプト)を処理する際に、AIは文字の羅列ではなく、トークン単位で情報を扱います。

これにはいくつか理由があります。

- 効率的なデータ処理: 文字一つ一つではなく、意味を持つ最小単位で処理することで、AIは効率的に大量のデータを学習・処理できます。

- 意味の把握: トークンは単なる文字の塊ではなく、ある程度意味的なまとまりを持っています。これにより、AIは単語やフレーズの意味をより正確に把握しやすくなります。

- 単語に縛られない柔軟性: 例えば、「走る」「走った」「走っている」は人間にとっては同じ「走る」という動詞に関連しますが、単語としては異なります。しかし、トークンによっては共通の部分を持つなど、単語の形に厳密に縛られずに意味を捉えるのに役立ちます。また、「ChatGPT」のような固有の単語や、「!」のような記号もトークンとして扱われます。

AIトークンはどのように数えられる?

AIサービスを利用する上で特に気になるのが、トークンがどのように数えられるかでしょう。AIの応答の長さや、利用料金に直結するからです。

トークンの数え方は、利用するAIモデルやサービスによって異なりますが、基本的な考え方は共通しています。

- 文章をAIが認識できる最小単位に分解する: 私たちが入力したプロンプトや、AIが出力する応答が、AIモデル独自のルールに従ってトークンに分解されます。

- 文字数とは異なる: トークン数は文字数と必ずしも一致しません。例えば、英語では一つの単語がほぼ一つのトークンになることが多いですが、日本語の場合は漢字、ひらがな、カタカナなどが組み合わさるため、英語に比べて文字数の割にトークンが多くなりやすい傾向があります。「こんにちは」が「こ」「んに」「ちは」のように複数のトークンに分かれたり、「東京都」が「東京」「都」と分かれたりすることもあります。短い単語でもトークンが複数になることもあります。

- 目安: サービス提供元は、だいたい「〇〇文字あたり約〇〇トークン」といった目安を示していることがあります。例えば、一般的な目安として「1000トークンあたり、英語で約750単語、日本語で約500〜700文字」と言われることがありますが、これはあくまで目安です。正確なトークン数は、各サービスのAPIなどが提供するツールで確認する必要があります。

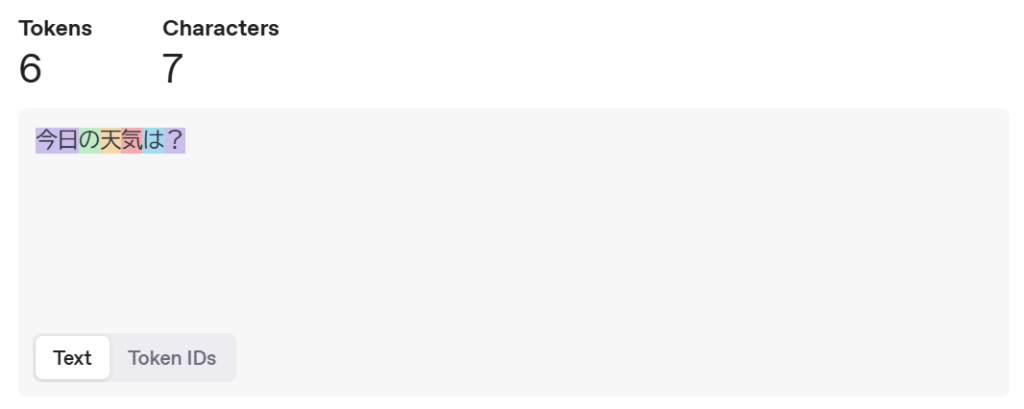

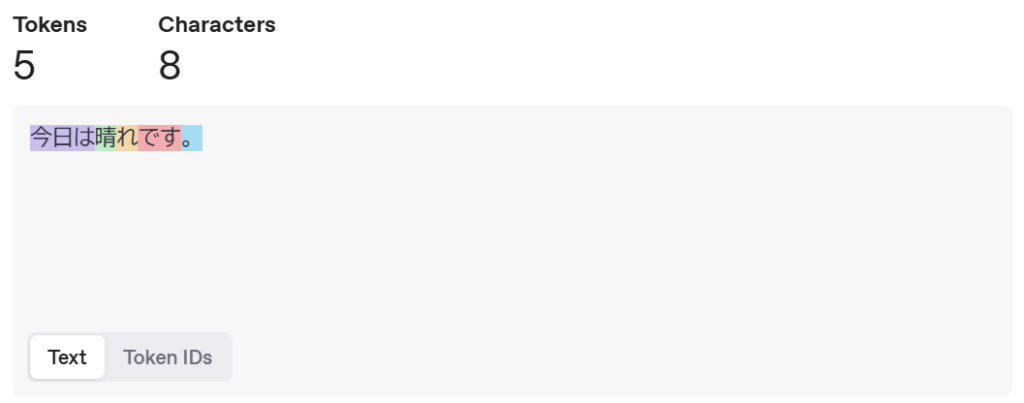

具体的なイメージ

もしあなたがAIに「今日の天気は?」と尋ねて、「今日は晴れです。」と答えが返ってきたとします。

この時、入力(プロンプト): 「今日の天気は?」 → これがいくつかのトークンに分解されます。

そして、出力(応答): 「今日は晴れです。」 → これもいくつかのトークンに分解されます。

この様に、入力と出力に使われたトークンの合計数が、そのやり取りで消費されたトークン数となります。

AIトークンの「数」と「料金」の関係

多くの有料AIサービスでは、利用料金がこの「トークン数」に基づいて計算されます。

一般的に、

- 入力トークン: 私たちがAIに送るプロンプトのトークン数。

- 出力トークン: AIが私たちに返す応答のトークン数。

この入力トークン数と出力トークン数の合計に対して、料金が発生します。料金体系は「1000トークンあたり〇〇ドル(または円)」のように設定されていることが多いです。

つまり、

- 長い文章をAIに入力するほど、入力トークンが増え、料金がかかります。

- AIから長い応答を引き出すほど、出力トークンが増え、料金がかかります。

AIとのやり取りが長くなればなるほど、消費するトークン数は増え、それに伴って料金も高くなる仕組みです。

先ほどの例の場合、モデルにもよりますが日本円で約0.035円程かかります。

料金の検証方法について、詳しくはこの記事で解説しています。

AIトークンを意識するメリット・活用例

AIトークンについて理解しておくと、AIをより賢く、効率的に使いこなせるようになります。

- コスト管理: 有料サービスを利用する場合、トークンと料金の関係を知っておけば、無駄なトークン消費を抑え、コストを意識した使い方ができます。「だらだらと長いプロンプトを送らない」「不要な長い応答を求めない」といった工夫に繋がります。

- プロンプトの最適化: AIはトークン単位で情報を処理するため、トークンの消費を意識することで、より洗練されたプロンプトを作成できます。例えば、「〇〇について簡潔に教えて」と指示することで、不要な長い応答を避けることができます。

- 処理能力の理解: AIモデルには「コンテキストウィンドウ」という、一度に処理できるトークンの上限があります。これを意識することで、「長すぎる文章は一度に処理できない」「過去の会話をどこまで覚えているか」といったAIの限界を理解し、適切なプロンプトの長さを調整できます。

- 応答の効率化: AIからの応答を短く、要点を絞ったものにしたい場合、プロンプトで「〇〇文字(あるいは〇〇トークン)以内で」といった指示を加えることが有効です。

具体的な活用例:

- 長い文章の要約: 元の文章が長すぎると、プロンプトだけでトークン上限に達してしまうことがあります。文章を分割してAIに渡したり、要約したい範囲を絞ったりする工夫ができます。

- 情報抽出: 「この文章から〇〇という情報を抜き出して、箇条書きでまとめて」のように、具体的な形式や長さを指定することで、効率的な応答を得られます。

- 多人数との会話: チャットAIとの会話では、過去のやり取りもトークンとして蓄積され、コンテキストウィンドウを消費します。会話が長くなると、AIが古い内容を忘れてしまうことがあるのは、コンテキストウィンドウの上限に達するためです。これを理解しておくと、適度なタイミングで会話をリセットするなどの対応ができます。

AIトークンに関する注意点・知っておくべきこと

AIトークンを利用する上で、いくつか注意しておきたい点があります。

- 日本語はトークン消費が多い傾向: 「なぜ!?」と思うかもしれませんが、日本語は構造上、同じ情報量でも英語より多くのトークンを消費しやすい傾向があります。日本語でAIを利用する場合は、よりトークン効率を意識する必要があります。

- コンテキストウィンドウの上限: AIモデルには、一度に処理できるトークンの上限(コンテキストウィンドウ)があります。これを超えると、AIは古い情報を「忘れて」しまいます。長い文章を入力したり、長い会話を続けたりする際には注意が必要です。

- トークン単価はモデルで異なる: AIモデルの種類(高性能なモデルや低コストなモデルなど)によって、1000トークンあたりの料金は異なります。目的に合わせて適切なモデルを選ぶことが重要です。

- サービスの進化: AI技術は日々進化しており、トークンの定義や数え方、料金体系なども変更される可能性があります。最新の情報は、利用しているAIサービスの公式情報を確認するようにしましょう。

まとめ:AIトークンを理解して賢くAIを使おう

AIトークンは、AIが人間の言葉を理解・処理するための「最小単位」であり、AIとのコミュニケーションやサービスの利用料金に深く関わっています。

トークン数を意識することは、有料サービスのコストを管理したり、AIへの指示(プロンプト)をより効果的にしたりするために非常に役立ちます。

特に、日本語での利用においてはトークン消費が多い傾向があることや、AIが一度に処理できるトークン数には上限がある(コンテキストウィンドウ)ことを知っておくことは重要です。

これからのAI時代を賢く、そしてお得に乗りこなすために知っておいて損はないでしょう。

よくある疑問:FAQ

Q1. トークン数が多いと、AIの応答はどうなりますか?

A1. 一般的に、プロンプトと応答の合計トークン数が、AIモデルが一度に処理できる上限(コンテキストウィンドウ)に近いほど、AIはより多くの情報を考慮して応答を生成できます。しかし、上限を超えると、AIは古い情報を忘れてしまい、応答の質が低下する可能性があります。また、単純にトークン数が多い(長い応答)ほど、料金は高くなります。

Q2. 自分の使ったトークン数はどこで確認できますか?

A2. 利用しているAIサービスやプラットフォームの管理画面や利用履歴で確認できる場合が多いです。特にAPIなどを利用している場合は、詳細な利用統計が表示されることが一般的です。無料のAIチャットサービスなどでは、ユーザーが直接トークン数を確認できない場合もあります。

Q3. トークンを節約する方法はありますか?

A3. はい、あります。プロンプトを簡潔にする、必要な情報だけを入力する、AIへの指示で応答の長さを指定する(例:「100文字程度で」「箇条書きで」)、あるいは低コストなAIモデルを選択するといった方法が有効です。無駄な長い応答を避けることも節約につながります。

Q4. 日本語の文章はなぜ英語よりトークンを多く消費しやすいのですか?

A4. AIモデルが言語をトークンに分解する際、アルファベット中心の英語に比べて、漢字・ひらがな・カタカナが混在する日本語は、区切り方や文字種が複雑なため、同じ情報量でも細かく分解され、結果としてトークンが多くなりやすい傾向があります。これはAIモデルの設計によるものです。

専門用語解説

- トークン: AI、特に大規模言語モデルがテキストを処理する際の最小単位。単語の一部、単語、句読点、記号などが該当する。

- 大規模言語モデル(LLM – Large Language Model): インターネット上のテキストデータなど、膨大な量のデータを学習して構築されたAIモデル。人間のような自然な文章を理解したり生成したりできる能力を持つ。

- プロンプト: AIに対して、ユーザーが入力する指示や質問のこと。

- コンテキストウィンドウ: AIモデルが一度に考慮できるトークンの上限数。この上限を超えると、AIはそれ以前の情報を参照できなくなり、「忘れて」しまう。AIが会話の流れや文脈を理解できる範囲を示す。